DiskursGlossar

Social Bots

Kategorie: Techniken

Verwandte Ausdrücke: Bots, Meinungs-Roboter

Siehe auch: Medien

Autor: Gregor Wiedemann

Version: 1.0 / Datum: 29.08.2025

Kurzzusammenfassung

Als Social Bots werden Computerprogramme bezeichnet, die in der Lage sind, in sozialen Medien Kommunikation menschlicher Nutzer*innen (teilweise) automatisiert nachzuahmen. Dazu zählt beispielsweise das Posten, Weiterleiten, Liken oder Beantworten von Inhalten. In der wissenschaftlichen Literatur gibt es keine einheitliche Definition des Phänomens. Uneinigkeit besteht vor allem darüber, wie ‚sozial‘ bzw. ‚intelligent‘ ein Bot sein muss, um als Social Bot zu gelten. Ebenso uneinheitlich ist die Einschätzung dazu, ob und in welchem Ausmaß von Social Bots Gefahren für demokratisch verfasste Gesellschaften ausgehen.

Aufgrund dieser Unsicherheiten sind Social Bots ein zentraler Gegenstand öffentlicher Kontroversen im Zuge der Digitalisierung der gesellschaftlichen Kommunikation. Zwar werden ihnen bisweilen auch nützliche, den Informationsbedürfnissen der Menschen zuträgliche Eigenschaften zugeschrieben. Dominiert wird der mediale und politische Diskurs aber durch die Vorstellung von Social Bots als mächtige Instrumente, mit denen verdeckt agierende Interessengruppen politische Debatten und demokratische Wahlen beeinflussen (Schlagwort). Der wissenschaftliche Diskurs steht bei der Überprüfung dieser Vorstellung vor der Herausforderung, dass verfügbare Datensätze über Social Bots die Wirklichkeit in den sozialen Medien nur ungenügend abbilden und dass Studien zum Einfluss von Bots nicht unter gleichen Bedingungen zu späteren Zeitpunkten wiederholt und damit überprüft werden können.

Der Ausdruck Bot wird in sozialen Medien mitunter auch als Stigmawort verwendet, um einem Kommunikationspartner ‚Unaufrichtigkeit‘, ‚abwegige Argumentation‘ oder ‚Naivität‘ vorzuwerfen.

Erweiterte Begriffsklärung

Im Sinne einer menschenzentrierten Gestaltung von Technik sollen (Chat-)Bots dabei helfen, Nutzer*innen automatisiert mit nützlichen Informationen zu versorgen. Als ‚Kommunikationsautomaten‘ reagieren Sie auf thematisch eng begrenzte Anfragen mit mehr oder weniger vordefinierten Antworten. Sie posten beispielsweise den aktuellen lokalen Wetterbericht, teilen mit, was es heute in der Mensa zum Mittag gibt oder informieren die Öffentlichkeit, wenn aus einer Bundesbehörde oder dem Bundestag heraus Wikipedia-Seiten bearbeitet werden. Das Wichtige dabei: sie geben sich als Bots samt ihrem Urheber zu erkennen, so dass ihre Kommunikationsinhalte entsprechend eingeordnet werden können. Weil auch Plattformen die Möglichkeiten, die durch automatisierte Kommunikation entstehen, durchaus schätzen, erlauben und regulieren sie den Einsatz von Bots (vgl. Makhortykh et al. 2022).

Die öffentliche Debatte in Politik und Medien dreht sich dagegen vor allem um verdeckt operierende Bots, die nicht offenlegen, dass ihre Kommunikationshandlungen von einem Automaten ausgeführt werden. So bleibt ebenfalls im Dunkeln, wer diesen Automaten betreibt und welche Absichten mit ihnen verfolgt werden. Der bösartige (‚malicious‘) Social Bot, so die Annahme, bestehe den Turing-Test (vgl. Ferrara et al. 2016): Im flüchtigen, oberflächlichen und verkürzten Social Media-Diskurs sind Nutzer*innen nicht mehr in der Lage zu unterscheiden, ob sie eine Konversation mit einem Menschen oder einer Maschine führen.

Die Befürchtungen sind nicht unbegründet. Es gibt zahlreiche Anreize, einen Bot oder ein ganzes Netz aus Bot-Accounts zu betreiben. ‚Content polluters‘, die Spam und Malware über automatisierte Accounts verbreiten, prägen bereits die frühen Jahre der Kurznachrichtenplattform Twitter (vgl. Lee et al. 2011). Das Hauptmotiv der meisten Bots ist Marketing bzw. Promotion, also die Verbreitung von Hashtags, Links und weiteren Inhalten auf sozialen Medienplattformen mit dem Ziel, Menschen dazu zu bringen eine bestimmte Website zu besuchen oder ein Produkt zu kaufen. Entsprechend voll ist Twitter, das seit 2023 X heißt, von automatisch generierten Nachrichten über fragwürdige Gesundheitsprodukte, Anleitungen, um garantiert schnell reich zu werden oder Links zu pornographischen Webseiten. Zu diesen Botschaften posten Bots populäre Hashtags ohne jeden inhaltlichen Bezug, um einen Teil der Aufmerksamkeit der Nutzer*innen auf sich zu lenken. Da diese Strategie allerdings nicht besonders ‚sozial‘ ist, führt sie auch nicht allzu viele Menschen hinters Licht. Die Plattformen haben in den letzten Jahren immer bessere Empfehlungsalgorithmen entwickelt, die als effektive Spamfilter in den personalisierten Newsfeeds der Nutzer*innen wirken. Wer es dennoch versuchen möchte, findet im Internet ohne Schwierigkeiten zahlreiche Angebote, sich Accounts und Follower*innen auf Plattformen wie X, Instagram und TikTok für wenig Geld zu kaufen.

Ein anderer Typ von Bots wird betrieben mit dem Ziel, die öffentliche Meinung auf sozialen Medienplattformen und mittelbar darüber hinaus zu beeinflussen. Über die künstliche Verstärkung von bestimmten politischen Positionen, positiven oder negativen Äußerungen über Politiker*innen oder die Verbreitung von Gerüchten und Fake News könnten Bots dazu beitragen Finanzmärkte zu destabilisieren, Wahlen zu beeinflussen (siehe Beispiel 1) oder Unruhen in der Bevölkerung anzustiften (vgl. Ferrera et al. 2016). Shao et al. (2018) zeigen beispielsweise, dass Bots überdurchschnittlich stark an der Verbreitung von Inhalten aus zweifelhaften Quellen beteiligt sind. Li et al. (2024) zufolge beeinflusse Bot-Interaktion auf Social Media Plattformen die Emotionalität von Äußerungen menschlicher Debattenteilnehmer negativ und beschädige über einen längeren Zeitraum damit das gesamte Diskursklima.

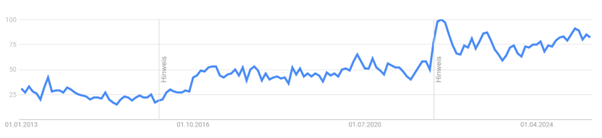

Insofern solche Forschungsergebnisse nicht nur eine spannende Geschichte erzählen lassen, sondern auch politische Entscheidungen im Bereich der inneren und äußeren Sicherheit und der Netzregulierung beeinflussen können, steigt das öffentliche Interesse und die Berichterstattung zum Thema seit Jahren an (vgl. Abb. 1).

Abbildung 1: Google Trends zum Suchbegriff „Social Bots“ (Google 2025).

Dabei sind die empirischen Befunde weniger eindeutig, als es der weitgehend einheitliche Tenor der medialen Berichterstattung über die „Invasion der Meinungsroboter“ (Hegelich 2016) vermuten lässt. Tatsächlich bemüht sich die Wissenschaft, seit es Social-Media-Plattformen gibt, verschleierte Kommunikation durch Bots zu erkennen, ihr Ausmaß zu quantifizieren, ihre Beiträge inhaltlich auszuwerten und ihre Wirkung auf menschliche Nutzer*innen zu ermessen. Sie scheitert dabei aber immer wieder zu einem gewissen Grad an der Schwierigkeit der Aufgabe, die in der Natur der Sache begründet liegt. Wenn bestimmte Bots sich nicht als solche zu erkennen geben, ist es schwierig, umfangreiche Datensätze zu erstellen, welche ihre Merkmale im Unterschied zu menschlichen Diskursteilnehmern zuverlässig erfassen. Der Forschung fehlt schlicht eine repräsentative und verlässliche ‚Ground Truth‘. Zwar gibt es Datensätze mit zehntausenden Bot-Accounts und menschlichen Accounts, mit denen maschinelle Lernverfahren zur Unterscheidung trainiert werden können (vgl. z. B. Feng et al. 2021). Die Qualität dieser Datensätze wird allerdings in zahlreichen Publikationen kritisiert (vgl. Martini et al. 2021; Hays et al. 2023). Die andauernde technische Entwicklung von Bots führe dazu, dass die in den Datensätzen enthaltenen Bot-Merkmale die tatsächlich aktiven Bots nur ungenügend abbilden. Zudem fallen bei qualitativen Prüfungen zahlreiche menschliche Accounts in den Datensätzen auf, die anhand einfacher Heuristiken fälschlich als Bots gelabelt wurden. Ohnehin stehen Forschenden nur die von einer Plattform veröffentlichten Daten zur Verfügung (Meta-Daten, Post-Inhalte, Nutzer-Statistiken). Auf Merkmale wie verifizierte Telefonnummern und E-Mail-Adressen, IP-Adressen, Geräte- und Browser-IDs können ausschließlich die Plattformen zugreifen. So bleiben trotz ausgetüftelter Systeme zur Bot-Detektion in der praktischen Anwendung zahlreiche Bots unerkannt. Noch häufiger werden menschliche Nutzer*innen von den Systemen fälschlicherweise als Bots klassifiziert (vgl. Rauchfleisch/Kaiser 2020; Gallwitz/Kreil 2022). Hinzu kommt, dass durch die andauernde Veränderung der Plattformen und ihrer Nutzerlandschaft Forschungsergebnisse zu einem späteren Zeitpunkt kaum reproduziert werden können (vgl. Martini et al. 2021).

Was beobachtet die Forschung aber dann, wenn sie nicht sicher sein kann, ob ein Account mit auffälligen Interaktionsmustern tatsächlich ein Bot ist? Als empirisch gesichert kann zumindest gelten, dass sich die Aktivitäten von Accounts zu bestimmten Zeiten, Themen und Standpunkten extrem ungleich verteilen. Um ein kommunikatives Ziel zu erreichen, zum Beispiel Hashtags zu einem plattformweiten Trend zu machen, die Sichtbarkeit für bestimmte Inhalte zu erhöhen oder Accounts positiv bzw. negativ zu sanktionieren, können sich einzelne Personen überdurchschnittlich stark engagieren oder Gruppen von Accounts zum gemeinsamen Handeln koordinieren (siehe bspw. die rechtsextreme Kampagne zum Hashtag #Stolzmonat, vgl. Deus 2024). Das ‚Bot-Sein‘ ist in diesem Sinne weniger eine binäre Eigenschaft eines Accounts, sondern ein Kontinuum der Abweichung des Verhaltens vom authentischen ‚Normalnutzer‘. Ein Teil der Forschung spricht darum inzwischen lieber von „coordinated inauthentic behaviour“ (de-Lima-Santos 2023), womit nicht zwingend unterstellt wird, dass der Social Media-Diskurs ausschließlich maschinell beeinflusst wird. Bezüglich der über Bots bzw. ‚inauthentischem Verhalten‘ verbreiteten Inhalte machen viele Studien allerdings ähnliche Beobachtungen: (teil-)automatisierte bzw. koordinierte Kampagnen und einzelne Superuser pushen in der Tendenz eher rechts-autoritäre Politiker*innen, Themen und Standpunkte mit emotionalisierten, inhaltlich oft zweifelhaften Text- und Bilddarstellungen (siehe Beispiel 1).

Insofern solche Aktivitäten die Verteilung von Meinungen in sozialen Medien im Vergleich zur tatsächlichen Verteilung in der Bevölkerung stark verzerren können, können sie für das Ideal eines demokratischen, deliberativen Diskurses zur politischen Willensbildung eine Herausforderung darstellen. Sollten Social Bots deshalb politisch reguliert werden oder ist ihr realer Einfluss vernachlässigbar? Oder sind über Bots geäußerte Botschaften gar als Verlängerung des Rechts auf freie Meinungsäußerung ihrer Urheber anzusehen und damit prinzipiell zu dulden? Ein Teil der Forschung legt nahe, dass der Einfluss von Social Bots auf die politische Kommunikation und insbesondere ihre Intelligenz in den Massenmedien und der Öffentlichkeit deutlich überschätzt wird (vgl. Assenmacher et al. 2020; Gallwitz/Kreil 2022). Eine Regulierung wäre folglich weder notwendig noch zielführend. Eine Kennzeichnungspflicht von Bots, wie sie beispielsweise der Bundesrat in einer Entschließung an die Bundesregierung im November 2018 gefordert hatte, sei Kritiker*innen zufolge ohnehin nicht praktikabel umsetzbar.

Die kritische Perspektive neigt bisweilen jedoch dazu, die komplexe Interaktion von unauthentischem koordiniertem Verhalten, (teil-)automatisierter Kommunikation und den Empfehlungsalgorithmen der Plattformen zu unterschätzen. Man kann die These vertreten, dass Betreiber*innen von Social Bots gar nicht anstreben, komplexe, individuelle Subjektidentitäten als Personae nachzubilden. Ihre Aufgabe ist stattdessen eine Art Megafonfunktion für ausgewählte Inhalte und Personen authentischer Accounts. Als Teil von koordinierten Kampagnen, bisweilen mit menschlicher Beteiligung, sollen durch Bot-Kommunikation nicht arglose Nutzer*innen in großer Zahl getäuscht, sondern möglichst viel zielgerichtete Aktivität auf einer Plattform erzeugt werden. Dabei wird so viel Interaktion mit authentischen Accounts angeregt, dass sogar für die Plattformen die Vorteile ihrer Existenz überwiegen. Bot-Accounts werden trotz weitreichender Detektions- bzw. Sanktionsmöglichkeiten durch die Plattformbetreiber eher zögerlich entfernt. Für die Megafonfunktion braucht es eine hohe Anzahl eher simpler Kommunikationsaktivitäten wie die massenhafte Verwendung bestimmter Hashtags, das automatische Herstellen von Follower-Beziehungen oder Weiterleitungen, Likes und (schematische) Antworten auf authentische Posts. Ab dem Überschreiten bestimmter Aktivitätsschwellen sorgen dann die Empfehlungsalgorithmen der Plattformen dafür, dass andere Nutzer*innen auf die so gepushten Inhalte aufmerksam werden, was zu vermehrter, diesmal authentischer Anschlusskommunikation führt – aus vorgetäuschter Aktivität wird echte Interaktion.

Die Möglichkeiten der Einflussnahme zur Verbesserung des Diskursklimas in den sozialen Medien liegen in dieser Perspektive bei den Plattformen, die Einfluss über die Moderation der Inhalte entlang ihrer Nutzungsbedingungen und das Design ihrer Empfehlungsalgorithmen nehmen können. Zudem können demokratisch gesinnte Diskursteilnehmer*innen noch besser darin werden, ihre Botschaften entlang der sozialen Medienlogiken (vgl. van Dijck/Poell 2013) für einzelne Plattformen aufzubereiten. Die Trägheit, mit der die demokratischen Parteien sich der Plattform TikTok angenähert haben, ließ beispielsweise der AfD lange Zeit, ihre Botschaften dort recht ungestört zu verbreiten (vgl. Wiedemann/Kessling 2025). Welchen Einfluss Plattformen bei der Setzung von Rahmenbedingungen haben, zeigt die Entwicklung von Twitter zu X. Seit der weitgehenden Einstellung der Inhaltemoderation im Zuge der Übernahme durch Elon Musk im Jahr 2022 haben Hassrede und Bot-Aktivitäten signifikant zugenommen (vgl. Hickey et al. 2024).

Beispiele

(1) Der Bot als Wahlbeeinflusser: Für mediales Aufsehen sorgen immer wieder wissenschaftliche Veröffentlichungen, die einen Einfluss von Bots auf Wahlen feststellen. In einer der meistzitierten Studien nehmen Bessi und Ferrara (2016) für die U.S.-Präsidentschaftswahl 2016 an, dass ca. ein Fünftel aller 2,8 Millionen Accounts, die sich zum Wahlkampf auf Twitter geäußert haben, Bots seien. Auch im Vorfeld öffentlicher Debatten zu Volksabstimmungen, so manche Studien, mischten sich Bots ein. Für das Brexit-Referendum geben Howard und Kollanyi (2016) an, dass fast ein Drittel aller thematisch einschlägigen Nachrichten von nur einem Prozent aller Accounts stammen und dazu beitragen, dass die Leave-Kampagne die Aktivitäten auf Twitter deutlich anführt. Mit ihrer vereinfachten Bot-Definition via „heavy automation“ als Accounts, die mehr als 50 Tweets pro Tag senden, bleibt aber tatsächlich offen, ob hier nicht vor allem besonders engagierte Menschen gezählt wurden. Für die Bundestagswahl 2017 stellen Keller und Klinger (2019) fest, dass der Anteil an Bot-Kommunikation während des Wahlkampfes von 7 % auf 10 % leicht angestiegen sei. Vor allem für AfD-bezogene Tweets falle ein überdurchschnittlicher Anteil hochaktiver, mutmaßlich automatisierter Accounts auf (vgl. Neudert et al. 2017). Für die brasilianischen Wahlen 2018 und 2023 identifiziert Pacheco (2024) stetig wachsende Botnetzwerke, die versuchen Einfluss auf die Wahlen zu nehmen.

Seit der Einstellung der Twitter API im Jahr 2023 ist die Botforschung deutlich zurückgegangen. Dass das Thema aber nach wie vor virulent ist, zeigt die Annullierung der ersten Runde der Präsidentschaftswahlen in Rumänien 2025. Das Verfassungsgericht hatte unter anderem durch koordinierte und automatisierte Kampagnen auf TikTok zur Unterstützung des rechtsextremen Kandidaten Călin Georgescu die Integrität des Wahlprozesses und die Chancengleichheit der Kandidaten als erheblich beeinträchtigt angesehen und eine Wiederholung der Wahl angeordnet. Auch für die Bundestagswahl 2025 kann auf TikTok eine Dominanz der AfD für alle Kennzahlen der Nutzerinteraktion festgestellt werden, die zumindest in Teilen einem großen Kreis unauthentischer Unterstützer*innen-Accounts zugeschrieben werden kann, die den TikTok-Algorithmus zur Lenkung von Aufmerksamkeit auf AfD-Inhalte anregen (vgl. Wetzel/Kiess 2025).

(2) Der Bot als Phantom: Wie bereits oben beschrieben ist Bot-Detektion ein schwieriges technisches Problem. Dass die Forschung zu Social Bots bis 2023 dermaßen erblühen konnte, ist im Wesentlichen zwei Umständen zu verdanken. Erstens ermöglichte die bis dahin offene Schnittstelle (API) von Twitter auf große Datenbestände zuzugreifen, um Merkmale von Bot-Kommunikation studieren zu können. Zweitens beschlossen Forscher*innen der Indiana University ihre Bot-Erkennung als Tool der Öffentlichkeit bereitzustellen. Mit BotOrNot, später umbenannt in Botometer, konnten andere Wissenschaftler*innen für einzelne Twitter-Accounts abfragen, wie wahrscheinlich es ist, dass ein Bot dahintersteckt (vgl. Varol et al. 2017). Das Tool arbeitet mit einem maschinellen Lernverfahren, dass auf einem sehr umfangreichen Datensatz trainiert wurde und über 1000 Merkmale von Twitter-Accounts in seine Bewertung einbezieht. Durch die offene API-Schnittstelle zum Tool können sehr große Listen von Accounts leicht überprüft werden, wodurch Botometer zum defacto-Standard der angewandten Bot-Forschung wurde. Und hier liegt der Hase im Pfeffer: Zwar funktioniert die Bot-Erkennung mit 94 % Genauigkeit auf den Testdaten hervorragend (ebd.). Sie generalisiert aber, wie häufig beim maschinellen Lernen, schlecht auf neue Datensätze mit anderen Merkmalszusammensetzungen (vgl. Hays et al. 2023). Kritiker*innen der Bot-Forschung verweisen darauf, dass sie bei qualitativen Überprüfungen von Samples mutmaßlicher, detektierter Botaccounts zwar viele hyper-aktive menschliche Nutzer*innen und den ein oder anderen automatisierten Account finden, aber nicht einen bösartigen Social Bot, der vorgibt ein Mensch zu sein, entdecken konnten (vgl. Gallwitz/Kreil 2022). In Cresci et al. (2025) reagieren Bot-Forscher*innen auf die harschen Vorwürfe und argumentieren, dass einzelne Kritiker*innen selbst unzulässig verallgemeinern und die fachinterne Debatte über Beschränkungen der etablierten Ansätze vernachlässigen. Als vorläufiges Ergebnis der Auseinandersetzung lässt sich festhalten, dass aufgrund schwer bestimmbarer Fehlerraten bei der Bot-Klassifikation Aussagen wie „Der Anteil von Bots am Diskurs X beträgt Y %“ eher mit Skepsis begegnet werden sollte. Aussagen wie der „Der Anteil der Bot-Kommunikation im Teildiskurs A ist [n-fach] höher als im Teildiskurs B“ können jedoch trotz hoher Fehlerraten zulässig sein, wodurch die Beobachtung des Anteils unauthentischer (Bot-)Kommunikation über die Zeit bzw. im Vergleich von unterschiedlichen Subdiskursen möglich wird.

Mit dem jüngsten Durchbruch in der Sprachtechnologie durch Large Language Models sind inzwischen tatsächlich Social Bots Realität geworden, die den Turing-Test bestehen (also von menschlicher Kommunikation nicht unterschieden werden) können, indem sie natürlichsprachige Texte unter Berücksichtigung zuvor erfolgter Kommunikationskontexte generieren und sogar Bildinhalte kommentieren können. Yang und Menczer (2024) analysieren beispielsweise ein Netzwerk aus 1140 Bot-Accounts auf Twitter, deren Inhalte mit ChatGPT generiert wurden. Ziel des Netzwerks ist es, Angebote rund um Kryptowährungen zu bewerben. Der Facebook-Konzern Meta verkündete bei einer Pressekonferenz im Dezember 2024, dass sie zwar zunehmend den Einsatz von KI-generierten Inhalten auf ihren Social-Media-Plattformen feststellten, diese aber bislang nur selten im Rahmen koordinierter Desinformationskampagnen, z. B. bei Wahlen zum Einsatz kämen (vgl. Booth 2024). Es ist allerdings nicht klar, wie belastbar solche Aussagen sind, da jüngste Ergebnisse zeigen, dass für LLM-getriebene Bots die bisherigen Ansätze der Bot-Erkennung weitgehend versagen (vgl. Yang/Menczer 2024;

Qiao et al. 2025).

(3) Der Bot als Begleiter: In eine ganz neue Richtung gehen KI-basierte Social Bots, die ihre Bot-Identität nicht mehr verschleiern, sondern als Persona öffentlich ausagieren. In einem Interview im Mai 2025 kündigte der Meta-Chef Mark Zuckerberg an, dass die Lücke zwischen dem Bedarf an Freundschaften und den tatsächlichen Freunden künftig durch KI-Begleiter gefüllt werden könnte. Entsprechend plant der Konzern auf seinen Plattformen Facebook und Instagram Bot-Profile einzufügen und mit Nutzer*innen interagieren zu lassen. Einen ähnlichen Service bietet seit mehreren Jahren die Firma Replika an, mit der man eine KI-basierte Variante seiner selbst oder einer anderen Person als Freund*in oder Partner*in, generieren kann, der/die einen durch das Leben begleitet. Diese Art von Social Bots könnte womöglich durch bislang kaum erforschte Effekte auf zwischenmenschliche Interaktionen ein destruktiveres Potenzial für die Gesellschaft entfalten, als die vermeintlich in großer Zahl verdeckt arbeitenden Diskursbeeinflusser.

(4) Bot als Stigmawort: Im nachfolgenden Beispiel aus X wird dem Kommunikationspartner (Autor 1) mit dem Ausdruck Bot eine ‚abwegige‘ oder ‚fingierte Argumentation‘ vorgeworfen, ohne damit behaupten zu wollen, es handle sich bei Autor 1 um einen automatisierten Kommunikationsagenten:

Autor 1: Der IS hat von 2014 bis 2017 laut der UN höchstens 5000 Jesiden ermordet und den Großteil dieser Bevölkerungsgruppe vertrieben. Nach deiner Logik kann das also kein Genozid sein, da sie doch weit mehr hätten töten müssen, wenn sie einen hätten begehen wollen. Merkst selbst, oder?

Autor 2: du bist so ein bot. merkst selbst oder ?

Autor 1: Nee, das ist ein Originalbeispiel von mir, das ich so woanders noch nicht gelesen habe. Nix Bot.

Literatur

Zum Weiterlesen

- Cresci, Stefano; Yang, Kai-Cheng; Spognardi, Angelo; Pietro, Roberto Di; Menczer, Filippo; Petrocchi, Marinella (2025): Demystifying Misconceptions in Social Bots Research. In: arXiv.

- Kreil, Michael (2017): Social Bots, Fake News und Filterblasen, Vortrag beim 34. Chaos Communication Congress (34C3), Online unter: https://media.ccc.de/v/34c3-9268-social_bots_fake_news_und_filterblasen#t=2390 ; Zugriff: 18.08.2025.

Zitierte Literatur

- Assenmacher, Dennis; Clever, Lena; Frischlich, Lena; Quandt, Thorsten; Trautmann,Heike; Grimme, Christian (2020): Demystifying Social Bots: On the Intelligence of Automated Social Media Actors. In: Social Media + Society, Jg. 6, Heft 3, S. 1–14.

- Bessi, Alessandro; Ferrara, Emilio (2016): Social bots distort the 2016 U.S. Presidential election online discussion. In: First Monday. Online unter: https://firstmonday.org/ojs/index.php/fm/article/view/7090.; Zugriff: 18.08.2025.

- Booth, Robert (2024): Meta says it has taken down about 20 covert influence operations in 2024. In: The Guardian, 3. Dezember 2024. Online unter: https://www.theguardian.com/technology/2024/dec/03/meta-says-it-has-taken-down-about-20-covert-influence-operations-in-2024 ; Zugriff: 04.06.2025.

- Cresci, Stefano; Yang, Kai-Cheng; Spognardi, Angelo; Pietro, Roberto Di; Menczer, Filippo; Petrocchi, Marinella (2025): Demystifying Misconceptions in Social Bots Research. In: arXiv. ID: arXiv:2303.17251 [cs].

- Deus, Fabian (2024): #STOLZ statt PRIDE – Struktur und kommunikationsstrategische Praktiken einer Online-Kampagne der Neuen Rechten. In: Forschungsgruppe Diskursmonitor (Hrsg.): Politisierung des Alltags: strategische Kommunikation in öffentlichen Diskursen. Siegen: universi, S. 35–50.

- Feng, Shangbin; Wan, Herun; Wang, Ningnan; Li, Jundong; Luo, Minnan (2021): TwiBot-20: A Comprehensive Twitter Bot Detection Benchmark. In: Proceedings of the 30th ACM International Conference on Information & Knowledge Management, Queensland Australia: ACM, S. 4485–4494.

- Ferrara, Emilio; Varol, Onur; Davis, Clayton; Menczer, Filippo; Flammini, Alessandro (2016): The Rise of Social Bots. In: Communications of the ACM, Jg. 59, Heft 7, S. 96–104.

- Gallwitz, Florian; Kreil, Michael (2022): Investigating the Validity of Botometer-Based Social Bot Studies. In: Spezzano, Francesca; Amaral, Adriana; Ceolin, Davide; Fazio, Lisa; Serra, Edoardo (Hrsg.): Disinformation in Open Online Media, Bd. 13545. Cham: Springer International Publishing, S. 63–78.

- Hays, Chris; Schutzman, Zachary; Raghavan, Manish; Walk, Erin; Zimmer, Philipp (2023): Simplistic Collection and Labeling Practices Limit the Utility of Benchmark Datasets for Twitter Bot Detection. In: Proceedings of the ACM Web Conference 2023, Austin: ACM, S. 3660–3669.

- Hegelich, Simon (2016): Invasion of the Social Bots. Berlin: Konrad Adenauer Stiftung.

- Hickey, Daniel; Schmitz, Matheus; Fessler, Daniel; Smaldino, Paul E.; Muric, Goran; Burghardt, Keith (2023): Auditing Elon Musk’s Impact on Hate Speech and Bots. In: Proceedings of the International AAAI Conference on Web and Social Media, Jg. 17, S. 1133–1137.

- Howard, Philip N.; Kollanyi, Bence (2016): Bots, #Strongerin, and #Brexit: Computational Propaganda During the UK-EU Referendum. In: SSRN Electronic Journal. Online unter: https://www.ssrn.com/abstract=2798311 ; Zugriff: 18.08.2025.

- Keller, Tobias R.; Klinger, Ulrike (2019): Social Bots in Election Campaigns: Theoretical, Empirical, and Methodological Implications. In: Political Communication, Jg. 36, Heft 1, S. 171–189.

- Lee, Kyumin; Eoff, Brian; Caverlee, James (2011): Seven Months with the Devils: A Long-Term Study of Content Polluters on Twitter. In: Proceedings of the International AAAI Conference on Web and Social Media, Jg. 5, Heft 1, S. 185–192.

- Li, Linda; Vásárhelyi, Orsolya; Vedres, Balázs (2024): Social Bots Spoil Activist Sentiment without Eroding Engagement. In: Scientific Reports, Jg. 14, Nr. 27005, S. 1-13.

- Makhortykh, Mykola; Urman, Aleksandra; Münch, Felix V.; Heldt, Amélie; Dreyer, Stephan; Kettemann, Matthias C. (2022): Not All Who Are Bots Are Evil: A Cross-Platform Analysis of Automated Agent Governance. In: New Media & Society, Jg. 24, Heft 4, S. 964–981.

- Martini, Franziska; Samula, Paul; Keller, Tobias R.; Klinger, Ulrike (2021): Bot, or Not? Comparing Three Methods for Detecting Social Bots in Five Political Discourses. In: Big Data & Society, Jg. 8, Heft 2, S. 1–13.

- Neudert, Lisa-Maria; Kollanyi, Bence; Howard, Philip N. (2017): Junk News and Bots during the German Federal Presidency Election: What Were German Voters Sharing Over Twitter? In: Data Memo 2017, Heft 2, S. 1–5.

- Pacheco, Diogo (2024): Bots, Elections, and Controversies: Twitter Insights from Brazil’s Polarised Elections. In: Proceedings of the ACM Web Conference 2024, Singapore: ACM, S. 2651–2659.

- Qiao, Boyu; Li, Kun; Zhou, Wei; Li, Shilong; Lu, Qianqian; Hu, Songlin (2025): BotSim: LLM-Powered Malicious Social Botnet Simulation. In: Proceedings of the AAAI Conference on Artificial Intelligence, Jg. 39, Heft 13, S. 14377–14385.

- Rauchfleisch, Adrian; Kaiser, Jonas (2020): The False Positive Problem of Automatic Bot Detection in Social Science Research. In: Zollo, Fabiana (Hrsg.): PLOS ONE, Jg. 15, Heft 10, S. 1–20.

- de-Lima-Santos, Mathias-Felipe; Ceron, Wilson (2023): Coordinated Amplification, Coordinated Inauthentic Behaviour, Orchestrated Campaigns. In: Mapping Lies in the Global Media Sphere. 1. Aufl., London: Routledge, S. 165–184.

- Shao, Chengcheng; Ciampaglia, Giovanni L.; Varol, Onur; Yang, Kai-Cheng; Flammini, Alessandro; Menczer, Filippo (2018): The Spread of Low-Credibility Content by Social Bots. In: Nature Communications, Jg. 9, Heft 1, S. 1–9.

- van Dijck, José; Poell, Thomas (2013): Understanding Social Media Logic. In: Media and Communication, Jg. 1, Heft 1, S. 2–14.

- Varol, Onur; Ferrara, Emilio; Davis, Clayton; Menczer, Filippo; Flammini, Alessandro (2017): Online Human-Bot Interactions: Detection, Estimation, and Characterization. In: Proceedings of the International AAAI Conference on Web and Social Media, Jg. 11, Heft 1, S. 280–289.

- Wetzel, Gideo; Kiess, Johannes (2025): Wahlkampfarena TikTok – Die AfD verliert ihre Dominanz – zumindest offiziell. In: Belltower News. Online unter: https://www.belltower.news/wahlkampfarena-tiktok-die-afd-verliert-ihre-dominanz-zumindest-offiziell-158355 ; Zugriff: 15.07.2025.

- Wiedemann, Gregor; Kessling, Phillipp (2025): Die Bundestagswahl 2025 auf TikTok. In: Zusammenhalt begreifen. Online unter: https://fgzrisc.hypotheses.org/5841 ; Zugriff: 18.08.2025.

- Yang, Kaicheng; Menczer, Filippo (2024): Anatomy of an AI-powered malicious social botnet. In: Journal of Quantitative Description: Digital Media, Jg. 4, S. 1–34.

Abbildungsverzeichnis

- Abb. 1: Google (2025): Social Bots. Interesse im zeitlichen Verlauf. Google Trends. Online unter: https://trends.google.de/trends/explore?cat=299&date=2013-01-01%202025-09-01&q=Social%20Bots&hl=de ; Zugriff: 17.10.2025.

Zitiervorschlag

Wiedemann, Gregor (2025): Social Bots. In: Diskursmonitor. Glossar zur strategischen Kommunikation in öffentlichen Diskursen. Hg. von der Forschungsgruppe Diskursmonitor und Diskursintervention. Veröffentlicht am 29.08.2025. Online unter: https://diskursmonitor.de/glossar/social-bots/.

DiskursGlossar

Grundbegriffe

Begriffsgeschichte

Die Begriffsgeschichte lässt sich allgemein als eine historische Methode beschreiben, die den zeitlichen Wandel der Bedeutungen von bestimmten Ausdrücken untersucht. Da einzelne Worte nie isoliert begegnen und ihre jeweiligen Bedeutungen erst im Kontext größerer sprachlicher Zusammenhänge oder semantischer Felder greifbar werden, verbindet sie sich flexibel mit anderen Methoden historischer Semantik, wie etwa der Diskursgeschichte, der Argumentationsgeschichte oder der Metaphernforschung (Metaphorologie).

Diskurssemantische Verschiebung

Mit dem Begriff der diskurssemantischen Verschiebung wird in der Diskursforschung ein Wandel in der öffentlichen Sprache und Kommunikation verstanden, der auf mittel- oder län-gerfristige Veränderung des Denkens, Handelns und/oder Fühlens größerer Gesellschafts-gruppen hinweist.

Domäne

Der Begriff der Domäne ist aus der soziologisch orientierten Sprachforschung in die Diskursforschung übernommen worden. Hier wird der Begriff dafür verwendet, um Muster im Sprachgebrauch und kollektiven Denken von sozialen Gruppen nach situationsübergreifenden Tätigkeitsbereichen zu sortieren.

Positionieren

Positionieren ist Grundbestandteil menschlicher Kommunikation. Wann immer wir miteinander interagieren und kommunizieren, bringen wir uns selbst, andere und die Objekte, über die wir sprechen, in bestimmte Relationen zueinander.

Deutungsmuster

Unter einem Deutungsmuster wird die problem- und lösungsbezogene Interpretation gesellschaftlicher und politischer Tatbestände verstanden, die Aussicht auf Akzeptanz in sozialen Gruppen hat. Der Begriff des Deutungsmusters hat Ähnlichkeit mit den Begriffen der Theorie und Ideologie. Meist werden gesellschaftlich verbreitete Leitdeutungen, die oft mit Schlagwörtern und Argumentationsmustern einhergehen (wie Globalisierung, Kapitalismus, Leistungsgesellschaft, Chancengleichheit etc.) als Beispiele für Deutungsmuster genannt.

Sinnformel

‚Wer sind wir? Woher kommen, wo stehen und wohin gehen wir? Wozu leben wir?‘ Auf diese und ähnliche existentielle Fragen geben Sinnformeln kondensierte Antworten, die in privaten wie sozialen Situationen Halt und Argumenten in politischen und medialen Debatten einen sicheren Unterbau geben können.

Praktik

Eine Praktik ist ein spezifisches, situativ vollzogenes und sinnhaftes Bündel von körperlichen Verhaltensweisen, an dem mehrere Menschen und Dinge beteiligt sein können (z. B. Seufzen, um Frust auszudrücken, oder einen Beschwerdebrief schreiben, Fußballspielen).

Kontextualisieren

Kontextualisieren wird im allgemeineren bildungssprachlichen Begriffsgebrauch verwendet, um das Einordnen von etwas oder jemandem in einen bestimmten Zusammenhang zu bezeichnen.

Narrativ

Mit der diskursanalytischen Kategorie des Narrativs werden Vorstellungen von komplexen Denk- und Handlungsstrukturen erfasst. Narrative in diesem Sinne gehören wie Schlagwörter, Metaphern und Topoi zu den Grundkategorien der Analyse von Diskursen.

Argumentation

Argumentation bezeichnet jene sprachliche Tätigkeit, in der man sich mithilfe von Gründen darum bemüht, die Richtigkeit einer Antwort auf eine bestimmte Frage zu erweisen. Das kann in ganz verschiedenen Situationen und Bereichen nötig sein, namentlich um eine poli-tische, wissenschaftliche, rechtliche, unternehmerische oder private Angelegenheit zu klären.

Techniken

AI-Washing/KI-Washing

Unter AI-Washing ist die Praxis von Unternehmen oder Organisationen zu verstehen, Produkte, Dienstleistungen oder Geschäftsmodelle mit dem Etikett „Künstliche Intelligenz“ (KI bzw. „Artificial Intelligence“ (AI)) zu versehen, obwohl deren tatsächlicher Einsatz von KI-Technologien entweder stark übertrieben, nur marginal vorhanden oder überhaupt nicht gegeben ist.

Dogwhistle

Unter Dogwhistle wird in Teilen der Forschung eine doppeldeutige Äußerung verstanden, die eine offene und eine verdeckte Botschaft an jeweils eine Zuhörerschaft kommuniziert.

Boykottaufruf

Der Boykottaufruf ist eine Maßnahme, die darauf abzielt, ein Ziel, also meist eine Verhaltensänderung des Boykottierten, hervorzurufen, indem zu einem Abbruch etwa der wirtschaftlichen oder sozialen Beziehungen zu diesem aufgefordert wird.

Tabuisieren

Das Wort Tabuisierung bezeichnet die Praxis, etwas Unerwünschtes, Anstößiges oder Peinliches unsichtbar zu machen oder als nicht akzeptabel zu markieren. Das Tabuisierte gilt dann moralisch als unsagbar, unzeigbar oder unmachbar.

Aus dem Zusammenhang reißen

Das Aus-dem-Zusammenhang-Reißen gehört in den Funktionskreis der Redewiedergabe bzw. der Wiedergabe kommunikativer Ereignisse. Es kann (1) als intentionale argumentativ-polemische Strategie für ganz unterschiedliche diskursive Zielsetzungen von Akteuren genutzt werden, oder (2) es kann SprecherInnen und SchreiberInnen in unbeabsichtigter, fehlerhafter Weise unterlaufen.

Lobbying

Lobbying ist eine Form strategischer Kommunikation, die sich primär an Akteure in der Politik richtet. Beim Lobbying wird ein Bündel von kommunikativen Tätigkeiten mit dem Ziel eingesetzt, die Entscheidungen von Personen mit politischem Mandat oder den Entstehungsprozess von neuen Gesetzestexten interessengeleitet zu beeinflussen.

Karten

Karten dienen dazu, Raumausschnitte im Hinblick auf ausgewählte Charakteristika so darzustellen, dass die Informationen unmittelbar in ihrem Zusammenhang erfasst und gut kommuniziert werden können. Dazu ist es notwendig, Daten und Darstellungsweisen auszuwählen und komplexe und oft umkämpfte Prozesse der Wirklichkeit in einfachen Darstellungen zu fixieren.

Pressemitteilung

Pressemitteilungen sind standardisierte Mitteilungen von Organisationen, die sich an Journalist:innen und andere Multiplikator:innen richten. Sie dienen der offiziellen und zitierfähigen Informationsweitergabe und übernehmen zugleich strategische Funktionen in der öffentlichen Kommunikation und Meinungssteuerung.

Shitstorm

Der Begriff Shitstorm beschreibt eine relativ junge Diskurskonstellation, die seit den 2010er Jahren an Bedeutung gewonnen hat und gemeinhin als Online-Wutausbruch bezeichnet wer-den kann.

Tarnschrift

Als Tarnschrift bezeichnet man unter den Bedingungen von Zensur und Verfolgungsrisiko veröffentliche Texte, die insbesondere in der strategischen Kommunikation des NS-Widerstands eine zentrale Rolle spielten.

Schlagwörter

Brückentechnologie

Ganz allgemein wird unter dem Schlagwort der Brückentechnologie sowohl in den öffentlichen Medien als auch in technisch und wirtschaftlich dominierten Kontexten eine Technologie verstanden, die zeitlich befristet eingesetzt werden soll, bevor in Zukunft der Übergang zu einer als sinnvoller eingeschätzten anderen Technologie möglich ist.

Deindustrialisierung

Der Ausdruck Deindustrialisierung (auch De-Industrialisierung oder als Verb deindustrialisieren) beschreibt im öffentlichen Sprachgebrauch eine negativ bewertete Form des Strukturwandels durch Rückgang von produzierendem Gewerbe.

Nachhaltigkeit

Nachhaltigkeit als ein Schlagwort des öffentlichen Diskurses bezieht sich ganz allgemein auf einen ressourcenschonenderen Umgang mit dem, was uns Menschen der Planet Erde bietet, mit dem Ziel, dass auch nachfolgende Generationen noch die Möglichkeit haben, ähnlich gut zu leben wie wir heute (Generationengerechtigkeit).

Echokammer

Der Begriff der Echokammer steht in seiner heutigen Verwendung vor allem im Zusammenhang mit der Nutzung Sozialer Medien. Er verweist metaphorisch auf einen digitalen Kommunikations- und Resonanzraum, in dem Mediennutzer*innen lediglich Inhalten begegnen, die ihre eigenen, bereits bestehenden Ansichten bestätigen, während abweichende Perspektiven und Meinungen ausgeblendet bzw. abgelehnt werden.

Relativieren

Der Ausdruck relativieren besitzt zwei zentrale Bedeutungsvarianten: In bildungssprachlichen und wissenschaftlichen Kontexten bezeichnet er eine analytische Praxis, bei der Aussagen, Begriffe oder Phänomene durch Bezugnahme auf andere Sachverhalte eingeordnet, differen-ziert und in ihrer Geltung präzisiert werden.

Massendemokratie

Geprägt wurde der Begriff Massendemokratie im ersten Drittel des 20. Jahrhunderts von völkisch-konservativen Akteuren (prominent darunter Carl Schmitt 1926). Der Ausdruck Masse hatte damals bei den bürgerlichen Eliten eine rundum bedrohliche Assoziation.

Kriegsmüdigkeit

Der Ausdruck Kriegsmüdigkeit bezeichnet die emotionale und physische Erschöpfung von Menschen, die einen Krieg erleben, sowie die gesellschaftliche und politische Ermüdung angesichts langanhaltender Konflikte. Er beschreibt den sinkenden Kampfeswillen bei Kriegsparteien und heute wird er auch für das wachsende Desinteresse an Kriegsthemen in Medien und Öffentlichkeit genutzt.

Woke

Der Ausdruck woke stammt aus dem afroamerikanischen Englisch und bezeichnete dort zunächst den Bewusstseinszustand der Aufgeklärtheit über die Verbreitung von rassistischen Vorurteilen und Diskriminierung unter Angehörigen ethnischer Minderheiten.

Identität

Unter Identität versteht man allgemein die Summe von Merkmalen, die Individuen oder sozialen Kollektiven – etwa Nationen, Organisationen oder sozialen Gruppen – als charakteristisch oder gar als angeboren zugeordnet werden.

Wohlstand

Unter Wohlstand sind verschiedene Leitbilder (regulative Ideen) zu verstehen, die allgemein den Menschen, vor allem aber den Beteiligten an politischen und wissenschaftlichen Diskursen (politisch Verantwortliche, Forschende unterschiedlicher Disziplinen usw.) eine Orientierung darüber geben sollen, was ein ‚gutes Leben‘ ausmacht.

Verschiebungen

Dehumanisierung

Mit Dehumanisierung bzw. Anthropomorphisierung werden solche kommunikativen Techniken und Praktiken bezeichnet, die Personen, Sachverhalten oder Gegenständen menschliche Eigenschaften ab- bzw. zusprechen. Dehumanisierung und Anthropomorphisierung können sowohl durch sprachliche Mittel als auch durch andere, z. B. bildliche, Zeichen vollzogen werden.

Kriminalisierung

Kriminalität meint ein Verhalten, das gegen ein Gesetz verstößt. Folglich bedeutet Kriminalisierung im engeren Sinne den Vorgang, durch den Verhalten ungesetzlich gemacht wird – indem Gesetze geschaffen werden.

Versicherheitlichung

In akademischen Kontexten wird Versicherheitlichung in Abgrenzung zu einem naiv-realistischen Sicherheitsverständnis verwendet. Dieses betrachtet Sicherheit als einen universell erstrebenswerten und objektiv feststellbaren Zustand, dessen Abwesenheit auf das Handeln von Akteuren zurückzuführen ist, die feindselig, kriminell, unverantwortlich oder zumindest fahrlässig agieren.

Ökonomisierung

Ökonomisierung wird in gegenwärtigen Diskursen in der Regel zur Bezeichnung von Prozessen verwendet, in denen die spezifisch wirtschaftlichen Funktions-Elemente wie Markt, Wettbewerb/Konkurrenz, Kosten-Nutzen-Kalküle, Effizienz, Gewinnorientierung in Bereiche übertragen werden, die zuvor teilweise oder ganz nach anderen Leitkriterien ausgerichtet waren

Moralisierung

Moralisierung verlagert Macht- und Interessenkonflikte in die Sphäre der Kommunikation von Achtung / Missachtung. Sie reduziert Ambivalenz zugunsten einer Polarisierung von gut und böse.

Konstellationen

Krise

Krise ist vom Wort mit fachsprachlicher Bedeutung zur Zeitdiagnose und einem zentralen Begriff der öffentlich-politischen Kommunikation geworden. Der öffentlich-politische Krisenbegriff ist dabei – unabhängig vom Gegenstand der Krise – in eine krisendiskurstypische Konstellation zur Begründung von krisenüberwindenden Handlungen eingebettet.

Partizipatorischer Diskurs

Partizipation ist mittlerweile von der Forderung benachteiligter Personen und Gruppen nach mehr Beteiligung in der demokratischen Gesellschaft zu einem Begriff der Institutionen selbst geworden: Kein Programm, keine Bewilligung mehr, ohne dass bestimmte Gruppen oder Personen dazu aufgefordert werden, für (mehr) Partizipation zu sorgen.

Skandal

Die Diskurskonstellation des Skandals zeichnet sich durch eine in den Medien aufgegriffene (bzw. durch sie erst hervorgerufene) empörte Reaktion eines erheblichen Teils der Bevölkerung auf einen tatsächlichen oder vermeintlichen Missstand aus. Die schuldhafte Verursachung dieses Missstandes wird dabei einem gesellschaftlichen Akteur zugeschrieben, dessen Handeln als ‚unmoralisch‘ gedeutet wird.

DiskursReview

Review-Artikel

Memes als moderne Propaganda – Eine sprach- und medienkritische Untersuchung

Digitale Kommunikationsformen prägen heutige gesellschaftliche Debatten weitaus stärker als die klassischen Medien. Ihr Einfluss auf die politische Meinungsbildung und die Ausbildung ideologischer Positionen ist inzwischen unverkennbar und zählt zu den markantesten Entwicklungen der digitalen Gegenwart. Besonders hervorzuheben sind Memes: Sie verbreiten sich schnell, arbeiten mit humoristischen Mitteln und verdichten komplexe Inhalte auf ein Minimum an Zeichen. In öffentlichen Diskursen werden sie daher nicht mehr als spielerisches Internetphänomen betrachtet, sondern als ernstzunehmendes Instrument politischer Kommunikation und den damit einhergehenden propagandistischen Strategien.

„Stadtbild“ – Eine gedankliche Chiffre im politischen Diskurs

Fragen Sie mal Ihre Töchter, was ich damit gemeint haben könnte, und wiederholte, er habe gar nichts zurückzunehmen und wolle an dieser Politik festhalten

Musk, Zuckerberg, Döpfner – Wie digitale Monopole die Demokratie bedrohen und wie könnte eine demokratische Alternative dazu aussehen?

Die Tech-Milliardäre Musk (Tesla, X,xAI) Zuckerberg (Meta), Bezos (Amazon) oder Pichai (Alphabet) sind nicht Spielball der Märkte, sondern umgekehrt sind die Märkte Spielball der Tech-Oligopolisten geworden.

Beobachtung zum Begriff „Diplomatie“ beim Thema Ukraine im Europäischen Parlament

Von EU-Vertretern waren zur Ukraine seit 2022 vor allem Aussagen zu hören, die sich unter dem Motto „as long as it takes“ beziehungsweise „so lange wie nötig“ für die Erweiterung der militärischen Ausstattung und der Verlängerung des Krieges aussprachen. Vorschläge oder Vorstöße auf dem Gebiet der „Diplomatie“ im Sinne von ‚Verhandeln (mit Worten) zwischen Konfliktparteien‘ gab es dagegen wenige, obwohl die klare Mehrheit von Kriegen mit Diplomatie beendet wurden (vgl. z.B. Wallensteen 2015: 142)

Die Macht der Worte 4/4: So geht kultivierter Streit

DiskursReview Die Macht der Worte (4/4):So geht kultivierter Streit Begleittext zum Podcast im Deutschlandfunk (1) Wörter als Waffen (2) Freund-Feind-Begriffe (3) Sprachliche Denkschablonen (4) So geht kultivierter StreitEin Text vonvon Friedemann VogelVersion: 1.0 /...

Die Macht der Worte 3/4: Sprachliche Denkschablonen

DiskursReview Die Macht der Worte (3/4):Sprachliche Denkschablonen Begleittext zum Podcast im Deutschlandfunk (1) Wörter als Waffen (2) Freund-Feind-Begriffe (3) Sprachliche Denkschablonen (4) So geht kultivierter StreitEin Text vonvon Friedemann VogelVersion: 1.0 /...

Die Macht der Worte 2/4: Freund-Feind-Begriffe

DiskursReview Die Macht der Worte (2/4): Freund-Feind-Begriffe Begleittext zum Podcast im Deutschlandfunk (1) Wörter als Waffen (2) Freund-Feind-Begriffe (3) Sprachliche Denkschablonen (4) So geht kultivierter StreitEin Text vonvon Friedemann VogelVersion: 1.0 /...

Die Macht der Worte 1/4: Wörter als Waffen

DiskursReviewDie Macht der Worte (1/4): Wörter als Waffen Begleittext zum Podcast im Deutschlandfunk (1) Wörter als Waffen (2) Freund-Feind-Begriffe (3) Sprachliche Denkschablonen (4) So geht kultivierter StreitEin Text vonvon Friedemann VogelVersion: 1.0 / 06.03.2025...

Relativieren – kontextualisieren – differenzieren

Die drei Handlungsverben relativieren, kontextualisieren, differenzieren haben gemein, dass sie sowohl in Fachdiskursen als auch im mediopolitischen Interdiskurs gebraucht werden. In Fachdiskursen stehen sie unter anderem für Praktiken, die das Kerngeschäft wissenschaftlichen Arbeitens ausmachen: analytische Gegenstände miteinander in Beziehung zu setzen, einzuordnen, zu typisieren und zugleich Unterschiede zu erkennen und zu benennen.

Wehrhafte Demokratie: Vom Wirtschaftskrieg zur Kriegswirtschaft

Weitgehend ohne Öffentlichkeit und situiert in rechtlichen Grauzonen findet derzeit die Militarisierung der ursprünglich als „Friedensprojekt“ gedachten EU statt.